http://fr.wikipedia.org/wiki/Loi_de_Moore

Related: 5.2. Construire un environnement numérique • Environnement numériqueLa folle évolution du stockage informatique Films HD, MP3, photos, projets professionnels… Chaque jour, sans même y penser, nous produisons – et donc devons stocker – une masse toujours plus grande de données. Pourtant, l’époque où l’on avait besoin de 12 disquettes pour lancer un logiciel sur un ordinateur Atari n’est pas si lointaine. Au fur et à mesure de l’évolution de nos ordinateurs, puis de nos téléphones, il a fallu imaginer de nouveaux moyens pour compiler et retrouver toutes ces informations. A l’heure du big data, le stockage, d’abord analogique, puis numérique, s’est donc adapté. Selon la loi de Kryder, du nom d’un ingénieur américain, nous pouvons techniquement doubler la capacité de nos disques durs tous les treize mois, tout en en divisant par deux le coût. Toujours plus d’espace, toujours moins cher : en 1981, le coût de stockage d’un mégaoctet (à peine une chanson MP3) était de 700 dollars.

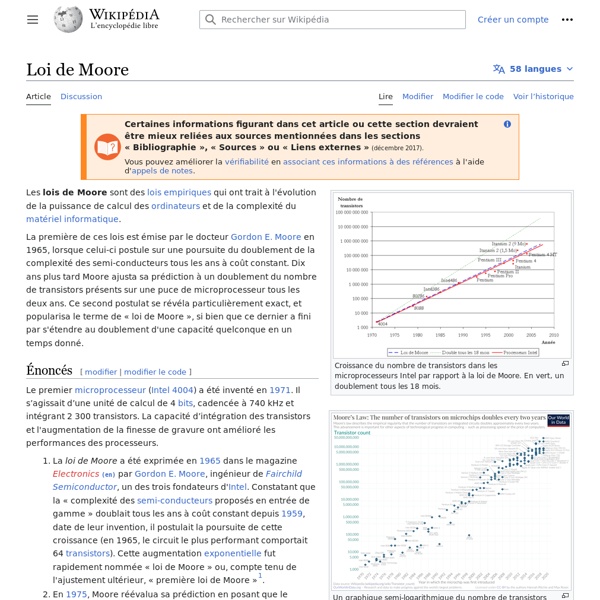

Processeurs : la loi de Moore c'est terminé. Quid de la suite ? En mars prochain l'industrie des semi-conducteurs va passer à autre chose : la loi de Moore, qui conduit la révolution de l'IT depuis les années 1960, n'aura plus cours. Cette règle stipule que le nombre de transistors sur un microprocesseur double à peu près tous les deux ans. Une amélioration exponentielle du matériel informatique qui a permis de transformer en bêtes de course les premiers ordinateurs, mais aussi de pousser sur le marché l'Internet haut débit, les smartphones ou encore voitures, frigos et thermostats connectés. L'industrie a su coller à la loi de Moore depuis les années 60.

L’Art social de la Révolution... - Pierre-Joseph Proudhon, Du pri... - INHA Introduction par Anne-Marie Bouchard Amalgamant le devenir historique des classes sociales (aristocratie et bourgeoisie) et le devenir social des formes de l’art (art pour l’art et art social), Pierre-Joseph Proudhon (1809-1865) propose dans Du principe de l’art et de sa destination socialeune lecture très personnelle de l’histoire de l’art des Égyptiens à Courbet, de laquelle il prétend extraire « la théorie la plus complète de l’art ». Le livre, qui paraît de manière posthume, est en effet une réponse à la demande de son ami Courbet d’un texte pour un catalogue, ainsi qu’à leurs interrogations communes sur le rôle social de l’art.

Stockage d'information Le stockage d'information est aujourd'hui assuré par un support d'information électronique, ou électromagnétique, qui, vu de l'utilisateur, peut être physique (disque dur, clé USB, etc.) ou virtuel (Internet dénommé le « nuage » (en anglais cloud voire en franglais « le cloud »), mais qui en l'état de la technologie est enregistré sur un support physique (SSD, disque dur, CD/DVD, bande magnétique, etc.). Ainsi, le terme de « dématérialisation » employé pour désigner le passage d'un support d'information papier à un support électronique est peu approprié, puisque ce dernier est lui aussi lié à du matériel. Le choix de la méthode de stockage se fait selon plusieurs critères : la fréquence d'utilisation ;les besoins capacitaires de l'information (taille) ;la criticité de l'information (coût, sécurité) ;La capacité de stockage et la vitesse d’accès à l'information. Classification des technologies de stockage[modifier | modifier le code] Positionnement des différents types de stockage.

Quel était le contenu du premier email de l’histoire ? Partage Tweet Email Art interactif Un article de Wikipédia, l'encyclopédie libre. L’art interactif est une forme d'art dynamique qui réagit à son public et/ou à son environnement, une nouvelle manière de désigner l'art numérique mais seul le traitement computationnel de l'information est virtuel[1]. Contrairement aux formes d'art traditionnelles où l'interaction du spectateur est surtout un événement mental – de l'ordre de la réception – l'art interactif permet différents types de navigation, d'assemblage, ou de participation à l'œuvre d'art, qui va bien au-delà de l'activité purement psychologique. Les installations artistiques interactives sont généralement informatiques et utilisent des capteurs, qui mesurent des événements tels que la température, le mouvement, la proximité, les phénomènes météorologiques que l'auteur a programmé de manière à obtenir des réponses ou réactions particulières.

Chronologie - Internet dans le monde - Dossiers 1957Dans le contexte de la Guerre froide, le ministère américain de la Défense souhaite trouver une solution au risque de blocage de la transmission des informations, alors centralisée, en cas d'attaque nucléaire sur son sol, par l'emploi d'un réseau tissé. Il crée ARPA : Advanced Research Projects Agency, qui conduira à la création d'ARPANET, ancêtre d'internet. Août 1968Présentation du réseau à l'armée américaine : le projet ARPANET (Advanced Research Projects Agency Network), proposant une communication décentralisée par paquets, est approuvé. En Grande-Bretagne, premier réseau à commutation de paquets.

Unité de mesure en informatique Un article de Wikipédia, l'encyclopédie libre. Les unités de mesure suivantes sont utilisées en informatique pour quantifier la taille de la mémoire d'un dispositif numérique (ordinateur, Baladeur numérique, etc.), l'espace utilisable sur un disque dur, une clé USB, la taille d'un fichier, d'un répertoire ou autre. On peut utiliser avec la plupart de ces unités : soit des préfixes binaires (kibi- multiplie par 210 soit 1 024 ; mébi- par 220 soit 1 048 576 ; gibi- par 230 soit 1 073 741 824, etc.)soit des préfixes du Système international d'unités (SI) (kilo- (k) multiplie par 1 000 ; méga- (M) par 1 0002 ; giga- (G) par 1 0003, etc.) Unités de taille de mémoire[modifier | modifier le code] Taille variable[modifier | modifier le code] Art numérique Certaines informations figurant dans cet article ou cette section devraient être mieux reliées aux sources mentionnées dans les sections « Bibliographie », « Sources » ou « Liens externes »(décembre 2016). Améliorez sa vérifiabilité en les associant par des références à l'aide d'appels de notes. L'art numérique désigne un ensemble varié de catégories de création utilisant les spécificités du langage et des dispositifs numériques, ordinateur, interface ou réseau. Il s'est développé comme genre artistique depuis la fin des années 1950[1].

Histoire d'Internet Le premier serveur web, actuellement au musée du CERN, étiqueté « This machine is a server. DO NOT POWER IT DOWN!! », ce qui signifie : « Cette machine est un serveur. NE PAS L'ÉTEINDRE !! » L'histoire d'Internet remonte au développement des premiers réseaux de télécommunication. Connaître son adresse IP gratuitement et rapidement > INFORMATIONS : Copyright Laurent Camus (sauf jeux, qui font l'objet d'un copyright de leurs auteurs) - En savoir plus, Aide, Contactez-nous [Conditions d'utilisation] [Conseils de sécurité] Reproductions et traductions interdites sur tout support (voir conditions) | Contenu des sites déposé chaque semaine chez un huissier de justice | Mentions légales / Vie privée / Cookies.

Hypertexte Un article de Wikipédia, l'encyclopédie libre. Lorsque les nœuds ne sont pas uniquement textuels, mais aussi audiovisuels, on peut parler de système et de documents hypermédias. Étymologie[modifier | modifier le code] Étymologiquement, le préfixe « hyper » suivi de la base « texte » renvoie au dépassement des contraintes de la linéarité du texte écrit. 5 systèmes d’exploitation pour snober Windows 10 (et Mac OS) Microsoft a commencé à déployer la semaine dernière, pour les préinscrits, Windows 10, la dernière version de son système d’exploitation (ou « OS », pour « operating system ») – le logiciel qui fait tourner le « cœur » d’un ordinateur. Mais si vous cherchez une alternative à ce système qui équipe la grande majorité des ordinateurs personnels dans le monde, ou à Mac OS, son principal concurrent commercial, une myriade de systèmes d’exploitation libres et gratuits basés sur Linux existent et ne sont qu’à quelques clics. Ubuntu, le classique C’est la distribution (« version ») Ubuntu qui a contribué à mieux faire connaître Linux au grand public.

Que peut faire votre fournisseur d'accès à Internet de vos données? Aux Etats-Unis, l’historique de navigation des internautes peut désormais être vendu au plus offrant par leur fournisseur d’accès à Internet (FAI). Après le Sénat, la Chambre des représentants a adopté à son tour, dans la nuit de mardi à mercredi, une résolution qui vient abroger les nouvelles règles adoptées par la Commission fédérale des communications (FCC) pour durcir les contraintes imposées aux opérateurs en matière de respect de la vie privée. Ceux-ci auraient notamment été tenus d’obtenir l’autorisation de leurs clients avant de collecter et de revendre leurs données personnelles à des fins publicitaires – notamment leur géolocalisation et leur historique de navigation. A lire aussi Quand le Congrès américain torpille la vie privée en ligne