Colab.research.google. Untitled. SVMs kernelizados requerem o cálculo de uma função de distância entre cada ponto do conjunto de dados, que é o custo dominante de .

O armazenamento das distâncias é um fardo para a memória, portanto elas são recalculadas em tempo real. Felizmente, apenas os pontos mais próximos do limite de decisão são necessários na maioria das vezes. As distâncias frequentemente calculadas são armazenadas em um cache. Se o cache estiver sendo debulhado, o tempo de execução aumentará para .O ( n características × n 3 observações ) Você pode aumentar esse cache chamando o SVR como model = SVR(cache_size=7000) Em geral, isso não vai funcionar. O SVM do kernel pode ser aproximado, aproximando a matriz do kernel e alimentando-o com um SVM linear. Untitled. Support Vector Regression (SVR) tem apresentado bons resultados na previsão de terremotos, manchas solares e outros tipos de fenômenos físicos que são considerados "imprevisíveis".

A análise de regressão é uma abordagem para modelar a relação entre um conjunto de variáveis $Y$ (variáveis dependentes) e variáveis explicativas $X$ (chamadas regressores ou ainda variáveis independentes). Um modelo que tem ganhando atenção ultimamente é o modelo de regressão por meio do SVM (Support Vector Machine) e é denominado Support Vector Regression (SVR). O SVR é extremamente robusto mesmo em espaços com muitas dimensões, isso é devido a optimização não depender da dimensão do espaço de input. Untitled. Ok, depois de passar algum tempo pesquisando no Google, descobri como poderia fazer o peso em python, mesmo com o scikit-learn.

Considere o seguinte: Untitled. Aqui você irá montar seu primeiro projeto de Machine Learning (Aprendizado de máquina) usando a linguagem Python.

O que veremos: Baixar e instalar o Python SciPy e obter o pacote mais útil para aprendizado de máquina em Python.Carregar um conjunto de dados e entender sua estrutura usando resumos estatísticos e visualização de dados.Criar 6 modelos de aprendizado de máquina e escolher o melhor. Se você é um iniciante em aprendizado de máquina e quer finalmente começar a usar o Python, este tutorial foi pensado em sua necessidade, vamos lá! Untitled. Há quem diga que saber criar e selecionar as melhores features para um modelo de Machine Learning é uma arte.

De fato é. Assim como a arte, você precisa saber elaborar, construir e refinar o seu modelo. Contudo, feature selection não precisa ser apenas arte, podemos utilizar de outros artifícios e técnicas para otimizar essa etapa. Untitled. Untitled. Traduzido de: A Complete Tutorial on Tree Based Modeling from Scratch (in R & Python) Por Analytics Vidhya Content Team Introdução.

› XGBoost: aprenda este algoritmo de Machine Learning em Python. XGBoost é um dos algoritmos mais utilizados por cientistas de dados, apresentando resultados superiores, principalmente em problemas de previsão envolvendo dados estruturados/tabulares.

Os dados tabulares são aquele tipo de estrutura similar ao que é usado pelo Pandas – DataFrames. Por suas características, consegue lidar eficientemente (e com robustez) com uma grande variedade de tipos diferentes de dados. Se você está lidando com problemas de regressão, pontuação ou classificação, definitivamente você precisa aprender a usar o XGBoost. Untitled. Por: DataLab Serasa Experian em 6 de fevereiro de 2019 Este texto corresponde ao primeiro de uma mini-série de três posts sobre algoritmos de boosting.

Cross validation strategy when blending/stacking. 10. Uma explicação visual para função de custo “binary cross-entropy” ou “log loss” Se você já treinou um classificador binário, você provavelmente usou a função de custo “binary cross-entropy” (entropia cruzada) ou “log loss”.

Mas você já pensou a respeito do que essa função de custo realmente significa? Hoje em dia, as bibliotecas e frameworks são tão fáceis de usar, que costumamos ignorar o verdadeiro significado da função de custo utilizada. Eu estava em busca de um artigo que explicasse de uma maneira clara, visual e breve os conceitos por trás da “binary cross-entropy” ou “log loss”, para mostrar aos meus alunos do Data Science Retreat. Mas como não encontrei nada que me agradasse, resolvi escrever eu mesmo :-) Imagine que temos 10 pontos aleatórios: x = [-2.2, -1.4, -0.8, 0.2, 0.4, 0.8, 1.2, 2.2, 2.9, 4.6]

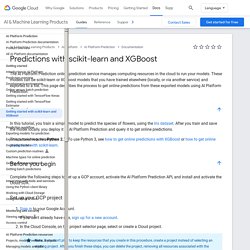

Como selecionar um algoritmo de aprendizado de máquina - Azure Machine Learning. Como selecionar um algoritmo de aprendizado de máquina - Azure Machine Learning. Roteiro de Machine Learning de algoritmos - Azure Machine Learning. Predictions with scikit-learn and XGBoost The AI Platform Prediction online prediction service manages computing resources in the cloud to run your models.

These models can be scikit-learn or XGBoost models that you have trained elsewhere (locally, or via another service) and exported to a file. This page describes the process to get online predictions from these exported models using AI Platform Prediction. In this tutorial, you train a simple model to predict the species of flowers, using the Iris dataset. After you train and save the model locally, you deploy it to AI Platform Prediction and query it to get online predictions. Dificuldades no Treinamento de Redes Neurais. Pré-requisitos Vou pressupor que você tenha os conhecimentos especificados no tutorial sobre matemática e programação para aprendizado de máquina, isto é, que sabe cálculo (derivadas), o básico de álgebra linear, de estatística e de programação. Eu também vou pressupor que você viu os tutoriais anteriores a esse.

Meus tutoriais são ordenados de maneira lógica e sugiro fortemente que você se atenha à ordem deles para maior compreensão. Conteúdo Gradientes Explodindo e Desvanecendo Como vimos no tutorial de backpropagation, para treinar redes neurais, computamos as derivadas de com respeito ao custo e atualizamos na direção oposta. Funções de Ativação. Redes neurais artificiais tiveram seu advento na década de 40 mas, até pouco tempo atrás, elas eram extremamente difíceis de treinar.

Esse fenômeno já era estudado desde os anos 90, mas só em 2010, com um paper de Xavier Glorot e Yoshua Bengio, é que começamos a entendemosder essa dificuldade a fundo. Capítulo 8 - Função de Ativação - Deep Learning Book. Neste capítulo estudaremos um importante componente de uma rede neural artificial, a Função de Ativação. Este capítulo é uma introdução ao tema e voltaremos a ele mais adiante quando estudarmos as arquiteturas avançadas de Deep Learning.

Este capítulo pode ser um pouco desafiador, pois começaremos a introduzir conceitos mais avançados, que serão muito úteis na sequência dos capítulos. Relaxe, faça a leitura e aprenda um pouco mais sobre redes neurais artificiais. Antes de mergulhar nos detalhes das funções de ativação, vamos fazer uma pequena revisão do que são redes neurais artificiais e como funcionam. Uma rede neural é um mecanismo de aprendizado de máquina (Machine Learning) muito poderoso que imita basicamente como um cérebro humano aprende. Teste para normalidade e homocedasticidade. A suposição de normalidade dos dados amostrais é uma condição exigida para a realização de muitas inferências válidas a respeito de parâmetros populacionais. Vários dos diferentes métodos de estimação e testes de hipóteses existentes foram formulados sob a suposição de que a amostra aleatória tenha sido extraída de uma população gaussiana.

Neste material vamos apresentar alguns testes que nos permitem verificar essa suposição. Também é importante salientar que além deles é fundamental observar a distribuição empírica dos dados por exemplo através do gráfico de densidade. Será apresentados alguns exemplos resolvidos com o R. É fortemente sugerido a leitura das referências ao final deste matrial para melhor compreensão de cada teste apresentado. Algoritmo de Classificação Naive Bayes. Utilidade O algoritmo “Naive Bayes” é um classificador probabilístico baseado no “Teorema de Bayes”, o qual foi criado por Thomas Bayes (1701 - 1761) para tentar provar a existência de Deus. Atualmente, o algoritmo se tornou popular na área de Aprendizado de Máquina (Machine Learning) para categorizar textos baseado na frequência das palavras usadas, e assim pode ser usado para identificar se determinado e-mail é um SPAM ou sobre qual assunto se refere determinado texto, por exemplo.

Por ser muito simples e rápido, possui um desempenho relativamente maior do que outros classificadores. Início - Deep Learning Book. Regularização — Machine Learning – mc.ai. Hoje irei falar sobre o nosso amigo que nos ajuda a combater o terrível pesadelo nomeado OVERFITTING. O que é regularização no aprendizado de máquina? - Quora. Regularização é uma forma de evitar o Overfitting, ou superajuste. Regularização — Machine Learning – mc.ai. Capítulo 20 - Overfitting e Regularização - Parte 2 - Deep Learning Book. How to fit an elephant. John von Neumann famously said With four parameters I can fit an elephant, and with five I can make him wiggle his trunk.

By this he meant that one should not be impressed when a complex model fits a data set well. Capítulo 19 - Overfitting e Regularização - Parte 1 - Deep Learning Book. O físico Enrico Fermi, ganhador do Prêmio Nobel de Física em 1938, foi questionado sobre sua opinião em relação a um modelo matemático que alguns colegas haviam proposto como a solução para um importante problema de física não resolvido.

O modelo teve excelente performance no experimento, mas Fermi estava cético. Ele perguntou quantos parâmetros livres poderiam ser definidos no modelo. “Quatro” foi a resposta. Bolsa 14/16147-3 - Dados composicionais, Regressão - BV FAPESP. Quais sãos as diferenças entre os modelos de regularização de regressões lineares Ridge e Lasso? - PRorum.com. Para lidar com o problema de regularização de regressão lineares, temos que resolver o seguinte problema de minimização:minβ‖y−Xβ‖22=minβn∑i=1(yi−Xiβ) sujeito a.

Google.com.br/url?sa=t&rct=j&q=&esrc=s&source=web&cd=6&ved=2ahUKEwjdhIPAw4rnAhX4FbkGHaQADhwQFjAFegQIARAB&url=http%3A%2F%2Fcursos.leg.ufpr.br%2FML4all%2Fapoio%2FRegularizacao.html&usg=AOvVaw2TRQZ8mpvWPIpKiKucWhob. Qual a diferença entre LASSO e Ridge Regression? – Data Mining / Machine Learning / Data Analysis. Eu sei que essa pergunta é velha, mas sempre que alguém não consegue entender alguma coisa é uma nova oportunidade de transmitir esse conhecimento de forma mais inteligente em um novo formato. Machine Learning - Regularização: Penalização Ridge e Lasso. › XGBoost: aprenda este algoritmo de Machine Learning em Python.

Algoritmo de Machine Learning que está dominando! Reinforcement Q-Learning from Scratch in Python with OpenAI Gym – LearnDataSci. Matriz de Confusão e AUC ROC - Marcos Silva - Medium. Quais os principais qual escolher? 10 Algoritmos de Machine Learning que você precisa conhecer.