Informatique. L'informatique est un domaine d'activité scientifique, technique, et industriel concernant le traitement automatique de l'information numérique par l'exécution de programmes informatiques par des machines : des systèmes embarqués, des ordinateurs, des robots, des automates, etc. Ces champs d'application peuvent être séparés en deux branches : théorique : concerne la définition de concepts et modèlespratique : s'intéresse aux techniques concrètes de mise en œuvre. Salle informatique de la bibliothèque d'Art et d'Archéologie de Genève Définitions[modifier | modifier le code] Computer science is no more about computers than astronomy is about telescopes — Hal Abelson[note 1]. « La science informatique n'est pas plus la science des ordinateurs que l'astronomie n'est celle des télescopes. » Étymologie[modifier | modifier le code] En 1966, l'Académie française consacre l'usage officiel du mot pour désigner la « science du traitement de l'information ».

Histoire[modifier | modifier le code] Trois mille ans d’informatique. L’informatique aussi a son histoire.

Des premières « tablettes numériques » sumériennes aux objets connectés, un ouvrage parcourt en images les évolutions techniques de ces machines à calculer qui ont révolutionné nos sociétés. Pierre Mounier-Kuhn, vous êtes chargé de recherche en histoire à la Sorbonne1 et au Centre Alexandre-Koyré2, et vous publiez avec Emmanuel Lazard, maître de conférences en informatique à l’université Paris-Dauphine, une Histoire illustrée de l’informatique. Comment replacez-vous la discipline informatique dans un cadre historique ? Pierre Mounier-Kuhn : Marginale jusqu’au milieu du XXe siècle, l’informatique est aujourd’hui devenue un phénomène historique massif : à la fois l’une des plus puissantes industries mondiales et une discipline scientifique bien établie.

Notre ouvrage vise d’abord à partager la richesse de cette histoire, qui remonte à la machine d’Anticythère, voire aux premiers chiffres écrits à Sumer. Advanced Micro Devices, Inc. Loi de Moore. Un article de Wikipédia, l'encyclopédie libre.

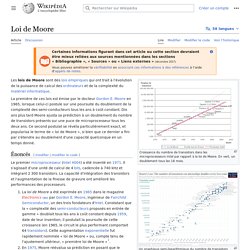

Les lois de Moore sont des lois empiriques qui ont trait à l'évolution de la puissance des ordinateurs et de la complexité du matériel informatique. Au sens strict, on ne devrait pas parler de lois de Moore mais de conjectures de Moore puisque les énoncés de Moore ne sont en fait que des suppositions. Il existe en fait trois « lois » de Moore, deux authentiques (au sens où elles furent émises par Gordon E. Moore), et une série de « lois » qui ont en commun de se prétendre « loi de Moore » mais qui n'en sont que des simplifications inexactes.

Croissance du nombre de transistors dans les microprocesseurs Intel par rapport à la loi de Moore. Énoncés[modifier | modifier le code] Le premier microprocesseur (Intel 4004) a été inventé en 1971. La Loi de Moore a été exprimée en 1965 dans « Electronics Magazine » par Gordon Moore, ingénieur de Fairchild Semiconductor, un des trois fondateurs d'Intel. Autres facteurs[modifier | modifier le code]

Code. Système d'exploitation. Logiciel. Système d'information. Données. Internet. Computer Science. Gérard Berry. File Management. Livres. Podcasts. Le Crabe Info – 1re communauté d'entraide informatique sur PC, Windows et Linux.