Comprendre : C’est quoi le Big Data ? Cloud et Big Data sont les deux grands mots-clés du moment Sommé par un journaliste de fournir une définition du concept lors du dernier EMC World, le CEO d’EMC avait tenté d’expliquer le concept par l’exemple : « Pour une compagnie pétrolière, le Big Data c’est la masse de données sismiques accumulées lors de recherche de nouveaux gisements de pétrole.

Pour un hôpital, ce serait plutôt l’imposant volume de données provenant des multiples scanners et instruments d’imagerie à résonance magnétique. Pour un studio de cinéma, ce serait plutôt les données générées lors du rendu d’un film 3D. L’important est que dans tous les cas on parle de volumes qui dépassent dès le départ le pétaoctet et qui progressent à vitesse exponentielle vers le multi-pétaoctets. CR du petit-déjeuner organisé par OCTO et Quartet FS « L’analyse décisionnelle en temps réel Convergence entre Big Data et Complex Event Processing » Agenda : Introduction aux enjeux d’analyse de données en temps réelPrésentation des architectures d’analyse de donnéesPrésentation de la solution Open Source ESPERPrésentation de la solution ActivePivot Sentinel (Quartet FS)Questions/Réponses Définition : « Un système d’analyse de données temps réel est un système évènementiel disponible, scalable et stable capable de prendre des décisions (actions) avec une latence inférieure à 100ms » 100ms est l’ordre de grandeur retenu lorsque l’on parle de « temps réel ».

Cette valeur permet de prendre les décisions dans un temps adapté au business. Quelles différences avec l’analyse traditionnelle ? Quels intérêts pour les entreprises ? Les entreprises sont déjà aujourd’hui confrontées aux problématiques de volumétrie. Big Data. Blueprint for a Big Data Solution. In today’s world, data is money.

Companies are scrambling to collect as much data as possible, in an attempt to find hidden patterns that can be acted upon to drive revenue. However, if those companies aren’t using that data, and they’re not analyzing it to find those hidden gems, the data is worthless. One of the most challenging tasks when getting started with Hadoop and building a big data solution is figuring out how to take the tools you have and put them together. The Hadoop ecosystem encompasses about a dozen different open-source projects. Ce que Hadoop ? Data warehouse, stockage et traitement distribués Définition Hadoop Hadoop est un projet Open Source géré par Apache Software Fundation basé sur le principe Map Reduce et de Google File System, deux produits Google Corp.

Le produit est écrit en langage Java. Network Attached Storage for Scalable Big Data Storage. Big Data : Ford veut explorer et combiner de nouvelles sources de données. Le Big Data, c’est le terme du moment.

Retiré le vernis marketing, reste une réalité, notamment technologique : exploiter des volumes croissants de données, structurées et non structurées (une ambition qui n'est pas nouvelle). Pour le constructeur Ford, le Big Data, c’est d’abord du décisionnel, de l’analytique, un domaine dans lequel il investit et étudie de nouvelles pistes. « Nous reconnaissons que les volumes de données que nous générons en interne – via nos divisions business et aussi via nous activités de recherche automobile aussi bien que par le biais de l’univers de données de nos clients et sur Internet – toutes ces choses représentent d’énormes opportunités pour nous qui nécessiteront probablement de manager de nouvelles techniques pointues et plates-formes » commente le responsable de l’analytique chez Ford, John Ginder. Une étude du cabinet Lecko L'Open Data au cœur de la nouvelle relation entre collectivités, entreprises et citoyens. Lundi 30 avril 2012 Les initiatives d'ouverture des données publiques, dites "Open Data", se multiplient, en France comme à l'étranger.

Moins d'un tiers des entreprises en France ont un projet Big Data, selon EMC/IDC. Cliquer sur l'image pour l'agrandir.

L'index Big Data mis en route par EMC et IDC évalue la perception des projets Big Data par les équipes IT en France. Pour 70% d'entre elles, il n'existe encore ni projet ni réflexion sur le sujet. Mais les équipes Etudes/BI sont déjà sollicitées par les métiers, tandis que celles chargées des infrastructures sont plus en retrait sur la question.

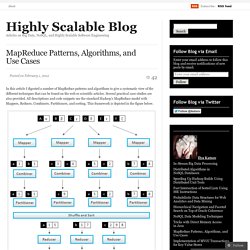

En France, les équipes informatiques ont une perception contrastée du concept Big Data, quoique globalement positive, constate IDC. Une perception qui diffère sensiblement, selon que l'on sonde, d'une part, les équipes Etudes et responsables des projets décisionnels, et d'autre part, les équipes chargées des infrastructures et de la production IT. De l'Informatique à l'Intelligence - Big Data à l'Heure de la Distribution. MapReduce Patterns. In this article I digested a number of MapReduce patterns and algorithms to give a systematic view of the different techniques that can be found on the web or scientific articles.

Several practical case studies are also provided. All descriptions and code snippets use the standard Hadoop’s MapReduce model with Mappers, Reduces, Combiners, Partitioners, and sorting. This framework is depicted in the figure below. MapReduce Framework Counting and Summing Problem Statement: There is a number of documents where each document is a set of terms. Solution: Let start with something really simple. The obvious disadvantage of this approach is a high amount of dummy counters emitted by the Mapper. In order to accumulate counters not only for one document, but for all documents processed by one Mapper node, it is possible to leverage Combiners: Applications: Log Analysis, Data Querying Collating Problem Statement: There is a set of items and some function of one item.

The solution is straightforward. L’évolution des architectures décisionnelles avec Big Data. Nous vivons une époque formidable.

En revenant un peu sur l’histoire de l’informatique, on apprend que les capacités que cela soit de RAM, disque ou CPU sont de grands sponsors de la loi de Moore au sens commun du terme (« quelque chose » qui double tous les dix-huit mois). Ces efforts seraient vains si les prix ne suivaient pas le phénomène inverse (divisés par 200 000 en 30 ans pour le disque par exemple). Exposé comme cela, on se dit que nos envies ne peuvent connaitre de limite et qu’il suffit de changer la RAM, le disque ou le CPU pour prendre en charge l’explosion du volume de données à traiter qui globalement suit bien la loi de Moore aussi.

Figure 1 Evolutions hardware, 2011, Alors où est le problème, qu’est qui fait que nos architectures décisionnelles aujourd’hui, non contentes de coûter de plus en plus chères, sont aussi en incapacité à se projeter sur des Tera ou des Peta de données. Big data : retour à la réalité. Hormis les experts dont on attend une forte maitrise du sujet, les incompréhensions autour du Big data sont peu à peu devenues des mythes a atteint des sommets.

J’ai donc décidé de prendre le temps de traiter ce problème en proposant une petite introduction à ce qu’est le Big data, et à ce qu’il n’est pas. Le Big data, ce n’est pas seulement une question de Volume de données massives, mais aussi de Variété et de Vélocité. Big Data, Big Value ? Les entreprises pas encore prêtes à affronter Big Data ? La croissance de la collecte de données n'a pas été suivie par la mise en place des outils et des équipes nécessaires à leur traitement. En revanche, les entreprises sont conscientes de souffrir d'un manque à gagner important.

Alors que Big Data est essentiel au développement des revenus, son rôle dans les entreprises est encore méconnu – il exige des stratégies spécifiques par secteur afin d’améliorer l’efficacité opérationnelle et l’expérience des consommateurs. L’étude Oracle réalisée le mois dernier - the Oracle Industries Scorecard - a interrogé les patrons américains sur le rôle de Big Data dans leurs entreprises. Beaucoup d’entre eux pensent qu’elles ne réagissent pas suffisamment vite aux données collectées et ne sont pas préparées à un « déluge de données », qui verrait tout à coup la quantité d’informations doubler.

Cette inefficacité et l’absence de préparation pourrait représenter un coût important en termes de manque à gagner et d’opportunités manquées. Big Data : le cauchemar peut être au rendez-vous par Stéphane Duproz - Chronique Solutions. L'accès au Net partout, la multiplication des terminaux et des services numériques ont généré un phénomène baptisé "Big Data" ou "grosses données". Soit une inflation telle d'informations qu'il devient difficile voire impossible de les gérer dans des bases de données classiques. Pour les entreprises, le Big Data peut devenir un cauchemar, un "Fat data" ou au contraire une formidable opportunité si elles savent la saisir.Le cauchemar, on le perçoit bien : envahie par les données (à titre d'exemple, 3 milliards de documents sont échangés chaque mois sur Facebook), ne sachant comment les traiter, l'entreprise se contente d'investir dans des baies de stockage qui au fil des mois vont prendre l'apparence de ces kilomètres de linéaires d'archives papiers qui croupissent dans les sous-sols de certaines grandes entreprises et administrations.

Cette vision est un immense gâchis car une donnée qui n'est plus utilisée devient un poids et surtout un centre de coûts. Big Data : les DSI restent sceptiques - Journal du Net Solutions. Le traitement des données en masse ne constitue pas un enjeu clé pour les entreprises. 32% des décideurs tablent sur une hausse des budgets analytiques et décisionnels d'ici 2014. Résultats exclusifs d'une enquête du cabinet Markess. Dans son référentiel de pratiques "De l'information à la prise de décision : nouveaux modes d'accès et d'analyse pour la performance du business, 2012-2014", Markess International fait le point sur le marché de l'analytique et du décisionnel en France. Les résultats de ce référentiel, tirés d'une étude approfondie menée par le cabinet auprès de 200 décideurs, ont été fournis au JDN en exclusivité. Parmi les principaux enseignements de ce référentiel de pratiques, on apprend que 66% des décideurs utilisent des solutions analytiques et décisionnelles, et que sur les 17% qui ont des projets prévus sur ce terrain, près de la moitié (41%) tablent sur un lancement de leur chantier d'ici la fin de l'année.

Lire l'article dans son intégralité.