Protege Ontology Library

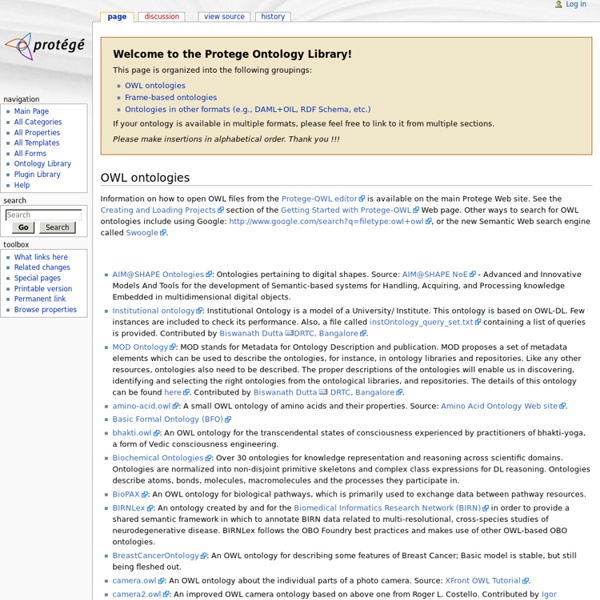

OWL ontologies Information on how to open OWL files from the Protege-OWL editor is available on the main Protege Web site. See the Creating and Loading Projects section of the Getting Started with Protege-OWL Web page. Other ways to search for OWL ontologies include using Google: or the new Semantic Web search engine called Swoogle. AIM@SHAPE Ontologies: Ontologies pertaining to digital shapes. Frame-based ontologies In the context of this page, the phrase "frame-based ontologies" loosely refers to ontologies that were developed using the Protege-Frames editor. Biological Processes: A knowledge model of biological processes and functions that is graphical, for human comprehension, and machine-interpretable, to allow reasoning. Other ontology formats Dublin Core: Representation of Dublin Core metadata in Protege.

SemanticWebTools - W3C Wiki

REDIRECT New SemanticWiki Tools Page As of 12:50, 14 January 2010, this page is no longer maintained and should not be changed. The content has been transferred to (Changes made here after the above date may not be reflected on the new page!) Please consult and possibly modify that page. Table of Contents: This page contains the information on RDF and OWL tools that used to be listed on the home pages of the RDF and OWL Working Groups at W3C. This Wiki page is only for programming and development tools. There are other pages on tool collection, largely overlapping with this, but possibly with a different granularity or emphasis. There are also separate pages maintained on this Wiki for: SPARQL implementations, set up by the SPARQL Working Group (although most of the information is present on this page, too) SPARQL "endpoints", examples of using SPARQL in exposing various data. Adobe's XMP Altova's SemanticWorks Amilcare Arity's LexiLink Asio Cerebra Server Rej

Cytoscape: An Open Source Platform for Complex Network Analysis and Visualization

CellDesigner

BiologicalNetworks

Web mining

Web mining - is the application of data mining techniques to discover patterns from the Web. According to analysis targets, web mining can be divided into three different types, which are Web usage mining, Web content mining and Web structure mining. Web usage mining[edit] Web usage mining is the process of extracting useful information from server logs e.g. use Web usage mining is the process of finding out what users are looking for on the Internet. Web Server Data: The user logs are collected by the Web server. Studies related to work [Weichbroth et al.] are concerned with two areas: constraint-based data mining algorithms applied in Web Usage Mining and developed software tools (systems). Web structure mining[edit] Web structure mining is the process of using graph theory to analyze the node and connection structure of a web site. 1. 2. Web content mining[edit] Web content mining is the mining, extraction and integration of useful data, information and knowledge from Web page content.

Related:

Related: