Ludwig Boltzmann Ludwig Eduard Boltzmann (February 20, 1844 – September 5, 1906) was an Austrian physicist and philosopher whose greatest achievement was in the development of statistical mechanics, which explains and predicts how the properties of atoms (such as mass, charge, and structure) determine the physical properties of matter (such as viscosity, thermal conductivity, and diffusion). Biography[edit] Childhood and education[edit] Boltzmann was born in Vienna, the capital of the Austrian Empire. Boltzmann studied physics at the University of Vienna, starting in 1863. Academic career[edit] In 1869 at age 25, thanks to a letter of recommendation written by Stefan,[1] he was appointed full Professor of Mathematical Physics at the University of Graz in the province of Styria. Ludwig Boltzmann and co-workers in Graz, 1887. In 1872, long before women were admitted to Austrian universities, he met Henriette von Aigentler, an aspiring teacher of mathematics and physics in Graz. Final years[edit] Physics[edit]

Loi binomiale Un article de Wikipédia, l'encyclopédie libre. En mathématiques, la loi binomiale de paramètres n et p est une loi de probabilité qui correspond à l'expérience suivante : On renouvelle n fois de manière indépendante une épreuve de Bernoulli de paramètre p (expérience aléatoire à deux issues possibles, généralement dénommées respectivement « succès » et « échec », la probabilité d'un succès étant p, celle d'un échec étant q = 1 - p). On compte alors le nombre de succès obtenus à l'issue des n épreuves et on appelle X la variable aléatoire indiquant ce nombre de succès. La variable aléatoire suit une loi de probabilité définie par : ou . , du fait que dans une combinaison l'ordre des éléments n'importe pas. et on obtient : Cette loi de probabilité s'appelle la loi binomiale de paramètres n et p et se note Bin(n ; p). Représentation sous la forme d'un arbre[modifier | modifier le code] Représentation de la loi binomiale sous forme d'un arbre. On retrouve bien évidemment que Donc par où C < 0,4784.

Kurt Gödel Kurt Friedrich Gödel (/ˈkɜrt ɡɜrdəl/; German: [ˈkʊʁt ˈɡøːdəl] ( ); April 28, 1906 – January 14, 1978) was an Austrian, and later American, logician, mathematician, and philosopher. Considered with Aristotle and Gottlob Frege to be one of the most significant logicians in history, Gödel made an immense impact upon scientific and philosophical thinking in the 20th century, a time when others such as Bertrand Russell,[1] A. N. Whitehead,[1] and David Hilbert were pioneering the use of logic and set theory to understand the foundations of mathematics. Gödel published his two incompleteness theorems in 1931 when he was 25 years old, one year after finishing his doctorate at the University of Vienna. He also showed that neither the axiom of choice nor the continuum hypothesis can be disproved from the accepted axioms of set theory, assuming these axioms are consistent. Life[edit] Childhood[edit] In his family, young Kurt was known as Herr Warum ("Mr. Studying in Vienna[edit]

Binomial distribution Binomial distribution for with n and k as in Pascal's triangle The probability that a ball in a Galton box with 8 layers (n = 8) ends up in the central bin (k = 4) is In probability theory and statistics, the binomial distribution is the discrete probability distribution of the number of successes in a sequence of n independent yes/no experiments, each of which yields success with probability p. Specification[edit] Probability mass function[edit] In general, if the random variable X follows the binomial distribution with parameters n and p, we write X ~ B(n, p). for k = 0, 1, 2, ..., n, where is the binomial coefficient, hence the name of the distribution. different ways of distributing k successes in a sequence of n trials. In creating reference tables for binomial distribution probability, usually the table is filled in up to n/2 values. Looking at the expression ƒ(k, n, p) as a function of k, there is a k value that maximizes it. and comparing it to 1. Recurrence relation where Example[edit]

John von Neumann John von Neumann (/vɒn ˈnɔɪmən/; December 28, 1903 – February 8, 1957) was a Hungarian and later American pure and applied mathematician, physicist, inventor, polymath, and polyglot. He made major contributions to a number of fields,[2] including mathematics (foundations of mathematics, functional analysis, ergodic theory, geometry, topology, and numerical analysis), physics (quantum mechanics, hydrodynamics, and fluid dynamics), economics (game theory), computing (Von Neumann architecture, linear programming, self-replicating machines, stochastic computing), and statistics.[3] He was a pioneer of the application of operator theory to quantum mechanics, in the development of functional analysis, a principal member of the Manhattan Project and the Institute for Advanced Study in Princeton (as one of the few originally appointed), and a key figure in the development of game theory[2][4] and the concepts of cellular automata,[2] the universal constructor, and the digital computer. . and

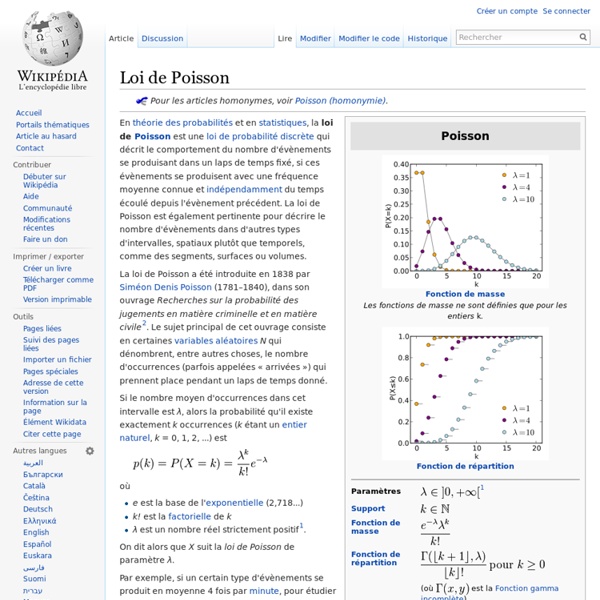

Loi de Bernoulli Un article de Wikipédia, l'encyclopédie libre. En mathématiques, la distribution de Bernoulli ou loi de Bernoulli, du nom du mathématicien suisse Jacques Bernoulli, est une distribution discrète de probabilité, qui prend la valeur 1 avec la probabilité p et 0 avec la probabilité q = 1 – p. En d'autres termes, ou, de manière équivalente, L'espérance mathématique d'une variable aléatoire de Bernoulli vaut p et la variance vaut p(1 – p). Le kurtosis tend vers l'infini pour des valeurs hautes et basses de p, mais pour p = 1/2 la distribution de Bernoulli a un kurtosis plus bas que toute autre distribution, c’est-à-dire 1. Variable de Bernoulli[modifier | modifier le code] Une variable aléatoire suivant la loi de Bernoulli est appelée variable de Bernoulli. Plus généralement, toute application mesurable à valeur dans {0,1} est une variable de Bernoulli. Distributions liées[modifier | modifier le code] Loi binomiale[modifier | modifier le code] Si Loi de Poisson[modifier | modifier le code] Soit On note

Andreï Kolmogorov Un article de Wikipédia, l'encyclopédie libre. Andreï Nikolaïevitch Kolmogorov Andreï Nikolaïevitch Kolmogorov (en russe : Андрей Николаевич Колмогоров ; 25 avril 1903 à Tambov - 20 octobre 1987 à Moscou) est un mathématicien soviétique et russe dont les apports en mathématiques sont considérables. Biographie[modifier | modifier le code] Enfance[modifier | modifier le code] Kolmogorov est né à Tambov en 1903. Kolmogorov fut scolarisé à l'école du village de sa tante, et ses premiers efforts littéraires et articles mathématiques furent imprimés dans le journal de l'école. Carrière[modifier | modifier le code] Après avoir terminé ses études secondaires en 1920, il suit les cours à l'Université de Moscou et à l'institut Mendeleïev. Après la fin de ses études supérieures en 1925, il commence son doctorat auprès de Nikolaï Louzine, qu’il termine en 1929. La même année, il devient directeur de l'Institut de mathématiques de l'université de Moscou. Contributions[modifier | modifier le code]

Loi uniforme discrète Un article de Wikipédia, l'encyclopédie libre. En théorie des probabilités, la loi discrète uniforme est une loi de probabilité discrète indiquant une probabilité de se réaliser identique (équiprobabilité) à chaque valeur d’un ensemble fini de valeurs possibles. Description[modifier | modifier le code] Une variable aléatoire qui peut prendre n valeurs possibles k1 , k2 , …, kn, suit une loi uniforme lorsque la probabilité de n’importe quelle valeur ki est égale à 1/n. Un exemple simple de loi discrète uniforme est le lancer d’un dé non biaisé. Dans le cas où les valeurs d’une variable aléatoire suivant une loi discrète uniforme sont réelles, il est possible d’exprimer la fonction de répartition en termes de distribution déterministe ; ainsi où H(x - x0) désigne la fonction marche de Heaviside, est la fonction de répartition (ou distribution cumulative) de la distribution déterministe centrée en x0, aussi appelée masse de Dirac en x0. Cas général[modifier | modifier le code] . où

Loi uniforme continue Un article de Wikipédia, l'encyclopédie libre. La loi uniforme continue est une généralisation de la fonction rectangle à cause de la forme de sa fonction densité de probabilité. Elle est paramétrée par les plus petites et plus grandes valeurs a et b que la variable aléatoire uniforme peut prendre. Caractérisation[modifier | modifier le code] Densité[modifier | modifier le code] La densité de probabilité de la loi uniforme continue est une fonction porte sur l'intervalle Fonction de répartition[modifier | modifier le code] La fonction de répartition est donnée par Fonctions génératrices[modifier | modifier le code] Fonction génératrice des moments[modifier | modifier le code] La fonction génératrice des moments est Fonction génératrice des cumulants[modifier | modifier le code] Propriétés[modifier | modifier le code] Statistiques d'ordre[modifier | modifier le code] Soit X1, ..., Xn un échantillon i.i.d. issu de la loi U(0,1). Ce fait est utile lorsqu'on construit une droite de Henry. par : et Si Soit

Mesure de Dirac Un article de Wikipédia, l'encyclopédie libre. Soient un espace mesurable et . On appelle mesure de Dirac au point , et l'on note , la mesure sur définie par : où Le support de est réduit au singleton . donc cette mesure est une probabilité sur . Les mesures de Dirac ont une utilité pratique ; elles permettent par exemple de construire des mesures par approximations successives. Portail de l’analyse Loi géométrique Un article de Wikipédia, l'encyclopédie libre. La loi géométrique est une loi de probabilité apparaissant dans de nombreuses applications. La loi géométrique de paramètre p (0 < p < 1) correspond au modèle suivant : On considère une épreuve de Bernoulli dont la probabilité de succès est p et celle d'échec q = 1 - p. On renouvelle cette épreuve de manière indépendante jusqu'au premier succès. Les valeurs de X sont les entiers naturels non nuls 1, 2, 3, ... On dit que X suit une loi géométrique de paramètre p. Calcul de p(k)[modifier | modifier le code] La probabilité p(k) correspond à la probabilité d'obtenir dans une succession de k épreuves de Bernoulli, k − 1 échecs suivis d'un succès. Définition alternative[modifier | modifier le code] On rencontre parfois pour la loi géométrique, la définition alternative suivante : la probabilité p'(k) est la probabilité, lors d'une succession d'épreuves de Bernoulli indépendantes, d'obtenir k échecs suivi d'un succès. mais de , c'est-à-dire . pour alors