Data Warehouse (entrepôt de données) définition : qu'est-ce que c'est ? Les Data Warehouse ou entrepôts de données sont des bases de données permettant de stocker des données historiques structurées non volatiles orientées sujet afin de les analyser. Découvrez la définition, les avantages, et les cas d’usage des Data Warehouses. Une Data Warehouse est une base de données relationnelle pensée et conçue pour les requêtes et les analyses de données, la prise de décision et les activités de type Business Intelligence davantage que pour le traitement de transactions ou autres usages traditionnels des bases de données. Les informations stockées dans la Data Warehouse sont historiques, et offrent une vue d’ensemble des différentes transactions qui ont eu lieu au fil du temps. The term "Data Lake", "Data Warehouse" and "Data Mart" are often times used interchangbly.

But what are exactly the differences between these things? This post attempts to help explain the similarity, the difference and when to use each. A high-level comparison of these three constructs is as below: NoSQL. NoSQL. Qu'est-ce que le data warehouse ? Présentation - Talend. Un data warehouse est un vaste gisement de données qui facilite la prise de décision dans l'entreprise.

Le concept de data warehouse date en fait des années 80. Il a été développé à cette époque pour faciliter la transition et le changement du rôle des données – de la simple consommation par les opérations à l'alimentation des systèmes d'aide à la décision qui allaient devenir la Business Intelligence. Image associé. Solutions de stockage Big Data : le tour de la question. Pourquoi c'est important pour vous ?

Pour comprendre comment mettre en place un projet de Big Data dans votre entreprise sans mettre le stockage au tapis. Il y a moins de dix ans, les possibilités de choix d'une solution de stockage pour Hadoop étaient finalement très mince : vous installiez des serveurs basiques pour calculer la données et le stockage Big Data était fourni par des disques connectés localement (DAS pour Direct Attached Storage). Et Hadoop allouait les tâches de traitement aux processeurs les plus proches des données concernées. L'ajout de stockage était aussi simple que l'ajout de nouveaux nœuds au cluster de calcul, avec l'avantage qu'une nouvelle puissance de traitement était greffée dans le même temps.

Problème : outre le fait que l'utilisation de DAS pour le stockage Big Data nuit à la gestion du stockage (conformité, contrôles réglementaires, et même sécurité), cette architecture était très peu flexible. Data Warehouse (entrepôt de données) définition : qu'est-ce que c'est ? La véritable histoire du Big Data. Le framework Apache Hadoop. Contexte Dans le monde du web actuellement, les applications et sites internet génèrent un volume de données de plus en plus important.

Top 6 des métiers du Big Data : Ingénieur Big data, Global Data analytics, .. Si vous êtes doté d’un talent particulier pour organiser, analyser ou comprendre les données, alors vous pouvez envisager une carrière en tant que Ingénieur Big Data ou plus globalement dans le secteur en plein essor du Big Data. Découvrez le top 6 des métiers du Big Data et du Cloud disponibles à l’heure actuelle. En 2015, Gartner prévoyait qu’il y aurait 6,4 milliards d’appareils connectés en circulation, soit 30% de plus que l’année précédente. D’ici 2020, ces analystes estiment que ce nombre atteindra 21 milliards. La prolifération de ces appareils engendre une immense quantité de données, structurées et non structurées. Selon un sondage mené par PwC, 61% des entreprises affirment être persuadées qu’elles doivent se focaliser davantage sur l’analyse de données pour ne pas être dépassées par la concurrence.

Youtube. Big data. Un article de Wikipédia, l'encyclopédie libre.

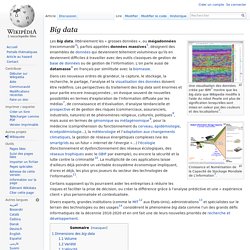

Une visualisation des données créée par IBM[1] montre que les big data que Wikipedia modifie à l'aide du robot Pearle ont plus de signification lorsqu'elles sont mises en valeur par des couleurs et des localisations[2]. Croissance et Numérisation de la Capacité de Stockage Mondiale de L'information[3]. Dans ces nouveaux ordres de grandeur, la capture, le stockage, la recherche, le partage, l'analyse et la visualisation des données doivent être redéfinis. Certains supposent qu'ils pourraient aider les entreprises à réduire les risques et faciliter la prise de décision, ou créer la différence grâce à l'analyse prédictive et une « expérience client » plus personnalisée et contextualisée.

Dimensions des big data[modifier | modifier le code] Le Big Data s'accompagne du développement d'applications à visée analytique, qui traitent les données pour en tirer du sens[15]. Volume[modifier | modifier le code] Variété[modifier | modifier le code] Big Data Evolution & challenges / Défis et évolution du Big Data. Big Data. Introduction à Apache Hadoop : généralités sur HDFS et MapReduce. Nous sommes actuellement dans l'ère de la production massive de données (BigData) dont une définition implique trois dimensions (3Vs) : Volume, Variété et Vélocité (fréquence).

Les sources de données sont nombreuses. D'une part les applications génèrent des données issues des logs, des réseaux de capteurs, des rapports de transactions, des traces de GPS, etc. et d'autre part, les individus produisent des données telles que des photographies, des vidéos, des musiques ou encore des données sur l'état de santé (rythme cardiaque, pression ou poids).

Un problème se pose alors quant au stockage et à l'analyse des données. La capacité de stockage des disques durs augmente mais le temps de lecture croît également. Il devient alors nécessaire de paralléliser les traitements en stockant sur plusieurs unités de disques durs. Apache Hadoop (High-availability distributed object-oriented platform) est un système distribué qui répond à ces problématiques.

III-A. III-B. III-C. IV-A. IV-A-1. IV-A-2. Introduction à Apache Hadoop : installation et configuration d'un cluster simple noeud avec Cloudera CDH 5. Pour télécharger Hadoop deux solutions sont disponibles.

La première solution est d'utiliser la version proposée par la fondation Apache. Cette version est celle de référence et contient le noyau et quelques interfaces d'aministration très simplifiée. La seconde solution est d'utiliser les distributions fournies par des entreprises qui font du service autour d'Hadoop. Comme il y a une valeur ajoutée non négligeable, ces distributions fournissent des services payants. Sans être exhaustif, voici trois sociétés qui font de Hadoop leur spécialité. Dans le cadre de cet article, j'utiliserai la distribution de la compagnie Cloudera. Par ailleurs, si l'on consulte le site de la fondation Apache, on se retrouve avec quatre versions majeures Hadoop.